html

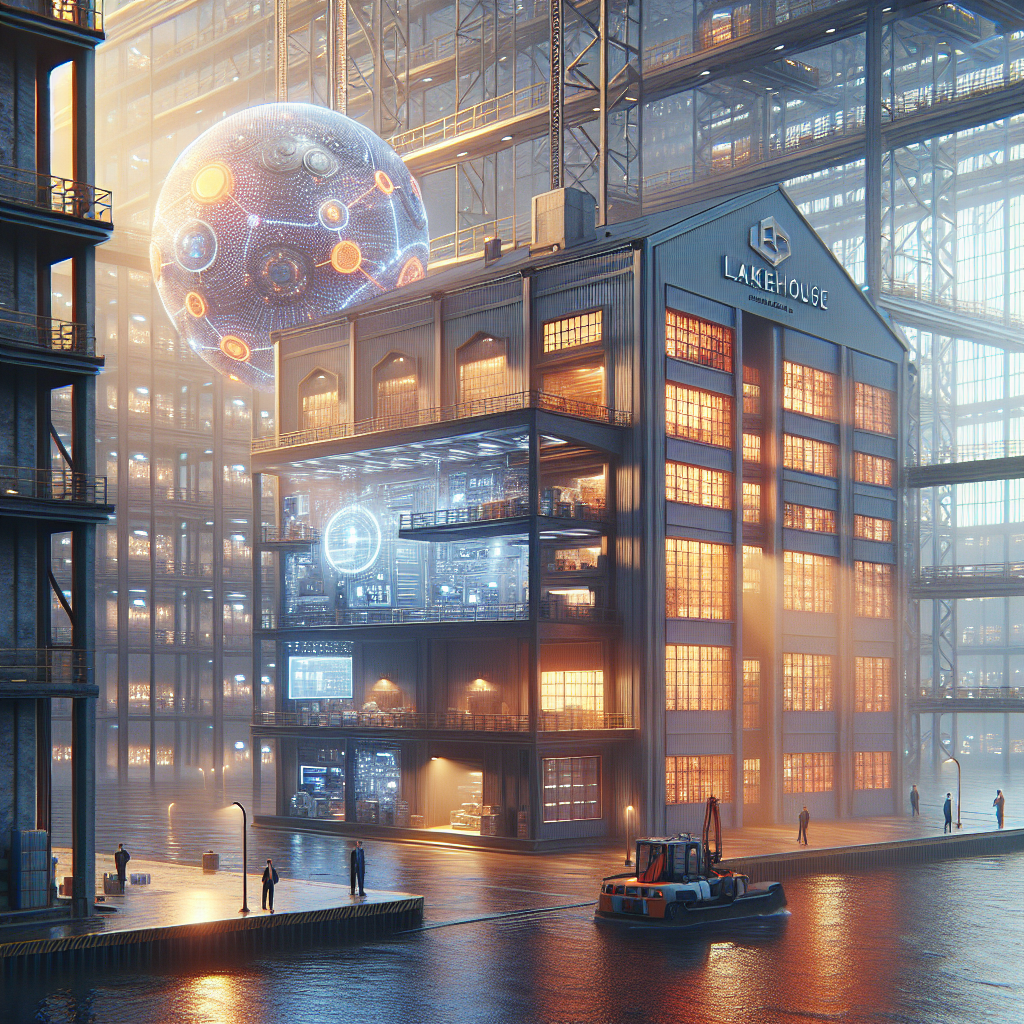

Introducción a Apache Flink CDC: Acelerando la Ingesta de Datos en Tiempo Real

En el paisaje digital actual, las organizaciones buscan constantemente maneras de aprovechar los datos en tiempo real para obtener información inmediata sobre el negocio. Las arquitecturas de datos tradicionales a menudo enfrentan problemas de latencia, desafíos de consistencia de datos y requisitos de infraestructura complejos. Aquí es donde Apache Flink CDC (Change Data Capture) se presenta como una solución transformadora para acelerar la ingesta de datos en arquitecturas de lakehouse en tiempo real.

Este artículo proporciona una guía completa sobre cómo Apache Flink CDC permite una ingesta de datos en tiempo real fluida, abordando las necesidades críticas de las empresas que requieren análisis de datos actualizados al instante y capacidades de toma de decisiones.

Comparativa entre Arquitectura de Lakehouse Tradicional y en Tiempo Real

Desafíos de Frescura de Datos y Soporte de CDC

Las arquitecturas de lakehouse tradicionales han servido bien a las organizaciones, pero presentan limitaciones inherentes que afectan los requisitos modernos de negocio:

- Desafíos de Frescura de Datos: En configuraciones convencionales, los datos operativos se ingieren en lagos de datos y se procesan utilizando motores de computación por lotes como Apache Spark, lo que resulta en ventanas de frescura de datos de una a tres horas.

- Soporte Limitado de CDC: Formatos tradicionales como Apache Iceberg tienen limitaciones en el manejo efectivo de logs de cambios, lo que hace que la actualización de registros existentes sea un proceso complejo.

- Complejidad de Infraestructura: Las canalizaciones de ingesta de CDC tradicionales requieren múltiples sistemas trabajando en coordinación, creando una infraestructura de datos difícil de mantener y escalar.

Beneficios de la Arquitectura de Lakehouse en Tiempo Real

La transformación hacia un lakehouse en tiempo real aborda estas limitaciones fundamentales al reemplazar el procesamiento por lotes con arquitecturas de streaming:

- Enfoque de Streaming Primero: Al reemplazar el procesamiento por lotes de Spark con Apache Flink, la latencia de los datos se reduce a minutos.

- Soporte Avanzado de Logs de Cambios: La migración de Iceberg a Apache Paimon mejora significativamente las operaciones de CDC.

- Arquitectura Unificada: Los lakehouses en tiempo real eliminan la complejidad de mantener múltiples sistemas al proporcionar un marco unificado de ingesta de datos en streaming.

Construyendo un Lakehouse en Tiempo Real: Los Cuatro Pilares

La creación de un lakehouse en tiempo real efectivo requiere una consideración cuidadosa de cuatro componentes esenciales:

- Ingesta de Datos en Streaming: Apache Flink CDC es la herramienta crítica que permite la captura fluida de datos desde diversas fuentes.

- Selección del Formato de Almacenamiento del Lakehouse: Elegir el formato de almacenamiento adecuado es crucial, siendo Apache Paimon ideal para arquitecturas de lakehouse en tiempo real.

- Requisitos del Motor de Procesamiento de Streaming: Apache Flink proporciona el poder computacional necesario para el procesamiento de datos en tiempo real.

- Integración del Motor de Análisis en Tiempo Real: Un motor OLAP en tiempo real como StarRocks es crucial para el análisis inmediato de datos.

Profundizando en Apache Flink CDC

Apache Flink CDC es una herramienta de ingesta de datos en streaming que implementa la lectura de snapshots unificados y la lectura incremental basándose en la tecnología CDC de bases de datos. Revoluciona la manera en que las organizaciones manejan la sincronización de datos al proporcionar un marco unificado para la captura de datos históricos y en tiempo real.

Capacidades de Captura y Procesamiento de Datos Unificados

- Captura de Datos Unificada: Flink CDC maneja automáticamente tanto datos de snapshots como datos incrementales en un solo marco.

- Lectura Automática de Logs: El sistema lee cambios incrementales directamente desde logs binarios de bases de datos.

- Entrega de Datos Consistente: Los sistemas downstream reciben un flujo de datos en tiempo real y consistente.

Evolución del Esquema: La Función Revolucionaria

Una de las características más poderosas de Apache Flink CDC es el soporte automático para la evolución del esquema. Cuando ocurren cambios en los esquemas de las bases de datos, Flink CDC aplica automáticamente estos cambios a las tablas downstream sin intervención manual.

- Eventos de Cambio de Esquema: Maneja eventos como agregar o eliminar columnas.

- Eventos de Cambio de Datos: Incluye operaciones de inserción, actualización y eliminación.

- Eventos de Flush: Aseguran la consistencia de los datos durante las transiciones del esquema.

Conclusión

Apache Flink CDC representa un cambio de paradigma en la ingesta de datos en tiempo real para arquitecturas de lakehouse modernas. Al proporcionar un marco unificado para la captura de datos, elimina la complejidad tradicional de las canalizaciones de CDC, entregando rendimiento y fiabilidad superiores.

Para más información sobre este tema, visita el artículo original en Alibaba Cloud Blog.

Nota: Este contenido original ha sido modificado con IA y revisado por un especialista.